O czym pamiętać w czasie pozycjonowania?

Spis treści:

- 1. Każdy projekt SEO jest niemal taki sam?

- 2. Rozbudowa treści nie jest lekiem na całe zło

- 3. Dane strukturalne w wynikach wyszukiwania są bardzo ważne

- 4. Podążanie za konkurencją to klucz do zwycięstwa

- 5. Szukaj domen z historią i linkami

- 6. Naprawiaj uszkodzone linki zwrotne

- 7. Używaj Google Analytics do typowania niepotrzebnych stron

- 8. Podczas przenoszenia strony nie korzystaj z narzędzia do usuwania adresów w GSC

- 9. Zwróć uwagę na grafiki

- 10. Zoptymalizuj meta description

- 11. Wyrażenia regularne w narzędziach Google

- 12. Pracuj nad mapą witryny

- 13. Korzystaj z mapy witryny do sterowania robotem

- 14. Rozważnie blokuj dostęp do zasobów w pliku robots.txt

- 15. Ostrożnie używaj narzędzia Google Disavow

- 16. Nie bój się używać plików SVG

- 17. Dopracuj swoje znaczniki title

- 18. Crawlowanie to nie indeksowanie

- 19. Twórz treści na bazie pytań od użytkowników

- 20. Różne znaczniki w różnych miejscach

- 21. Używaj różnych narzędzi do analizy odnośników

- 22. Przygotuj się na migrację strony

- 23. Używaj strony w wersji HTTPS

- 24. Nie korzystaj z tagu keywords

- 25. Obserwuj swoją stronę

- 26. Uważaj na wyskakujące reklamy

- 27. Przygotuj się na zapytania głosowe

- 28. Ustal jasną strukturę nagłówków na stronie

- 29. Pomóż Google ocenić swoją lokalną stronę

Dobrych rad nigdy za wiele, zwłaszcza jeśli chodzi o pozycjonowanie stron internetowych. Zasady, które zmieniają się bardzo szybko, są zależne nie tylko od wiedzy, umiejętności i doświadczenia specjalistów, ale przede wszystkim od Google. Wiele już o tym napisano i powiedziano, ale my postaramy się dorzucić kilka swoich sugestii.

Większość spośród 200? 250? czynników wpływających na ranking strony i słowa kluczowego w wynikach wyszukiwania nie jest znana. Część z nich Google przedstawia jako wytyczne dla webmasterów, o innych wiemy z wypowiedzi (oficjalnych, lub nieoficjalnych) pracowników firmy. Spora grupa tych czynników jest wynikiem wewnętrznych testów, obserwacji i wymiany doświadczeń.

Oprócz tych składowych mających wpływ na algorytm, w branży i wśród klientów utarło się sporo mitów dotyczących pracy w SEO, sposobu działania itp.

Wiele zależy od punktu widzenia i konkretnego przypadku, dlatego też tak często słyszymy w SEO „to zależy…”.

Poniżej zebraliśmy kilka porad, które nieco ułatwią pozycjonowanie stron lub pozwolą na inne spojrzenie na proces SEO.

Zanim przejdziemy do konkretnych punktów warto nadmienić, że podobne zestawienia pojawiają się niemal co roku na różnych portalach dotyczących SEO zarówno w Polsce, jak i za granicą. Zapewne część z przedstawionych tutaj informacji nie będzie nowością, liczę jednak na to, że zebrane przez nas rady pozwolą nieco usystematyzować lub pogłębić wiedzę o SEO.

1. Każdy projekt SEO jest niemal taki sam?

Z perspektywy klienta agencji SEO tak właśnie może to wyglądać, zwłaszcza gdy co miesiąc otrzymuje on informację o napisanych treściach, pozyskanych odnośnikach lub widzi efekty optymalizacji swojej strony internetowej. Za tymi działaniami kryje się o wiele więcej czynności, które polegają głównie na analizie witryny. Pomimo że możemy mieć taką samą tematykę strony, ten sam skrypt i podobną domenę jest wiele czynników, które mogą wpłynąć na to, że jedna domena odniesie sukces, a inna nie. Zakres prac prowadzonych nad każdą stroną jest inny niż działania prowadzone dla kolejnego projektu. Techniki i działania, które spowodowały, że strona A zwiększyła widoczność w organicznych wynikach wyszukiwania, nie dają gwarancji tego samego dla domeny B.

2. Rozbudowa treści nie jest lekiem na całe zło

Nie każda treść musi być rozbudowywana i aktualizowana by rankowała wysoko w wynikach wyszukiwania. Jest wiele treści, które się nie zmieniają, a ich aktualizacja i rozbudowa nie wpłynie znacząco na wyniki strony w Google.

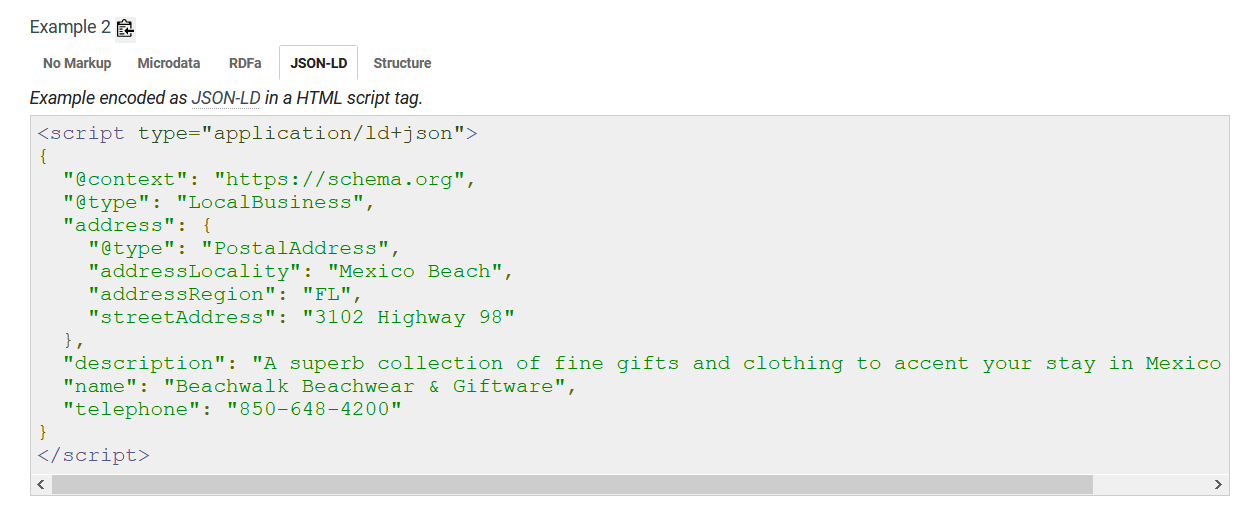

3. Dane strukturalne w wynikach wyszukiwania są bardzo ważne

Jasne! Należy ich używać do oznaczania swojej strony. Dzięki temu Google nie będzie mieć problemów z jej kategoryzowaniem, a w dodatku wyświetli w wynikach wyszukiwania kilka dodatkowych funkcjonalności, takich jak gwiazdki, breadcrumbs lub listę pytań i odpowiedzi. Więcej na ten temat pisaliśmy w artykule: Rich Snippets – jak praktycznie podejść do fragmentów rozszerzonych?.

4. Podążanie za konkurencją to klucz do zwycięstwa

Praca nad stronami klientów to czasem konieczność wcielenia się w SEO detektywa. Za pomocą programów dokonuje się analizy konkurencji pod kątem pozyskanych odnośników oraz ich rozkładu na poszczególne anchory, sprawdza się też kondycję witryny, jej optymalizację i frazy kluczowe. Wszystko to po to, by sprawdzać co w kontekście SEO robi nasza konkurencja. Opóźniony start w tym wyścigu może nas z niego dość szybko wyeliminować, więc śledzenie witryn konkurencyjnych i podążanie za trendami w SEO jest kluczowym działaniem analitycznym.

5. Szukaj domen z historią i linkami

Wbrew niektórym opiniom warto szukać domen, które mają już pewną historię i linki przychodzące. Znalezienie i weryfikacja takiej domeny może zapewne trochę potrwać, ale za to już na starcie strony buduje się przewagę nad konkurentami. Nie ma znaczenia, czy ta domena zostanie przekierowana na naszą stronę, czy będzie ona miejscem, gdzie ta strona powstanie czy też wykorzystamy ją jedynie do linkowania strony – warto to robić. Oczywiście trudno jest trafić na idealną domenę, a jeśli już się to udaje, nierzadko trzeba zainwestować spore środki by taką domenę kupić, ale sumarycznie jest to opłacalny interes.

6. Naprawiaj uszkodzone linki zwrotne

Duże znaczenie w SEO mają odnośniki kierujące do domeny. Czasem zdarza się tak, że z uwagi na zmianę oprogramowania lub zmiany w asortymencie niektóre podstrony przestają istnieć. Koniecznie należy sprawdzać stronę pod kątem „urwanych linków przychodzących”, a gdy uda się taki stan rzeczy wykryć, należy szybko reagować. Najlepszym wyjściem będzie ustanowienie przekierowania 301 ze starego adresu na nowy. Dzięki temu nie stracimy tego, co wymagało sporo pracy, a linki zewnętrzne pomogą nam w podnoszeniu pozycji strony w rankingu.

7. Używaj Google Analytics do typowania niepotrzebnych stron

Google Analytics jest narzędziem, które dostarcza ogromu danych. Narzędzie to można również wykorzystać w pozycjonowaniu stron, o czym pisałem w artykule: Jak korzystać z Google Analytics podczas pozycjonowania stron?. Warto jednak dodać jeszcze jedną wskazówkę. Raz na jakiś czas (w zależności od złożoności serwisu) warto przeprowadzić audyt w Google Analytics. Jeśli znajdziemy tam strony, które mają treść, ale w badanym okresie nie miały ruchu (lub był on bardzo mały) możemy te strony usunąć z indeksu za pomocą blokady indeksacji (noindex) lub pomyśleć o poprawie lub przeredagowaniu tych treści.

8. Podczas przenoszenia strony nie korzystaj z narzędzia do usuwania adresów w GSC

Gdy zmieniasz stronę lub domenę, poprawiasz strukturę lub przenosisz strony, nie korzystaj z narzędzia do usuwania adresów URL w Google Search Console. To narzędzie nie służy do szybszego wyindeksowania takich podstron, a jedynie do wyłączenia ich z widoku w indeksie. Więcej o tym napisałem w artykule: Czasowe usunięcie adresów z indeksu Google. Wykonanie odpowiednich przekierowań lub ustawienie kodu błędu strony i powiadomienie Google o zmianach wystarczy do tego, by Google przyswoiło informacje o nowym adresie bądź zmianach na stronie. Czasem trwa to dłużej, innym razem zmiany są widoczne niemal natychmiast, ale nie ma potrzeby angażowania do tego narzędzia, które, w tym przypadku, bardziej zaszkodzi niż pomoże.

9. Zwróć uwagę na grafiki

W wielu branżach bardzo istotne jest, by oprócz wysokich pozycji w organicznych wynikach wyszukiwania być też wysoko na dane zapytanie w Google Grafika. W tym celu należy pamiętać, by wszystkie obrazki były na stronie reprezentowane przez tag html img. Umieszczenie ich w CSS nie spowoduje, że Google do nich dotrze. Tam gdzie to możliwe ustaw też atrybut alt dla obrazka. Nie każde zdjęcie musi go posiadać. Atrybut ten powinien opisywać zawartość obrazka, nie jest to miejsce na upychanie słów kluczowych. Obrazki powinny być dobrej jakości, bo takie są lepiej oceniane przez algorytm Google i mają większe szanse na znalezienie się wysoko w Google Grafika. Warto też pomyśleć o dodaniu do strony mapy XML z obrazkami, podobnej do mapy witryny w wersji XML.

10. Zoptymalizuj meta description

Opis strony, który jest zawarty w znaczniku meta description jest ważnym elementem wpływającym na CTR z wyników wyszukiwania. Znacznik ten nie ma bezpośredniego wpływu na pozycje strony, ale jeśli jest napisany w sposób poprawny, może dość znacząco podnieść ilość przejść do naszej strony z organicznych wyników wyszukiwania. Google sugeruje, by stworzyć indywidualne opisy meta description dla najważniejszych podstron. Wiemy też, że lepszą praktyką jest pozostawienie opisu pustego niż używanie powielonego meta description w obrębie innych podstron serwisu. W takich przypadkach Google zamiast opisu description wyświetli fragment treści ze strony – najczęściej pobierze go z początku treści. Warto o tym pamiętać w czasie optymalizacji treści pod frazy kluczowe.

11. Wyrażenia regularne w narzędziach Google

Wyrażenia regularne przydają się bardzo w pracy nad zbiorami danych. Z ich dobrodziejstw można było korzystać np. w Google Analytics podczas tworzenia nowego celu. Teraz można wykorzystywać je także w Google Search Console dzięki filtrowi danych, który umożliwia użycie wyrażeń regularnych.

12. Pracuj nad mapą witryny

Mapa strony w wersji XML jest bardzo przydatnym narzędziem, które powinny posiadać przede wszystkim duże serwisy z wieloma podstronami. Taka mapa to zbiór podstron serwisu, które chcemy indeksować. Należy więc przed jej wygenerowaniem usunąć z niej adresy podstron, które zwracają kod błędu 404, są zablokowane przed indeksacją lub są przekierowane np. za pomocą przekierowania 301 na inny adres. W mapie witryny nie powinny się też znaleźć podstrony, które wskazują kanonicznie na inną stronę w serwisie. Taka mapa powinna być zgłoszona do Google w narzędziu Google Search Console. Dzięki temu robot crawlujący stronę będzie mógł skorzystać z danych w mapie do szybszego i pełniejszego zaindeksowania podstron.

13. Korzystaj z mapy witryny do sterowania robotem

Robot indeksujący stronę www podąża własnymi ścieżkami – trafia na stronę dzięki zaproszeniu z Google Search Console, linkom zewnętrznym lub mapie witryny. Pobiera zawartość strony, analizuje ją i umieszcza w indeksie wyszukiwarki. Wiedzą tajemną nie jest to, że robot nie dociera do wszystkich podstron z uwagi na tzw. budżet crawlowania. W dużych serwisach zdarza się często, że robot Google odwiedza wszystkie podstrony raz, albo z tak małą częstotliwością, że nie jest w stanie nadążyć za zmianą treści na stronie. Z pomocą w takim przypadku przychodzą nam logi serwera. Na ich podstawie możemy określić jakie podstrony odwiedza często robot Google, a których stron nie chce zbyt często oglądać. Mając zbiór stron niechętnie odwiedzanych przez robota możemy dodać je do nowej mapy witryny, która będzie odświeżana np. raz w miesiącu. Efekt jest taki, że po 1-2 iteracjach strony, które do tej pory nie były chętnie odwiedzane przez Google są znacznie częściej crawlowane, a cache dla takich stron ma znacznie świeższą datę i zawiera nowsze informacje.

14. Rozważnie blokuj dostęp do zasobów w pliku robots.txt

Plik robots.txt jest pierwszym plikiem, który odwiedza robot, sprawdzając, czy może wejść na daną podstronę i ją crawlować. Należy bardzo rozważnie umieszczać dyrektywy w tym pliku. Przede wszystkim trzeba uważać na blokowanie dostępu bota do zasobów JavaScript lub CSS, które są niezbędne do pełnego wyrenderowania strony. Należy też zwrócić uwagę na samą składnię polecenia – wielokrotnie spotykałem błędnie zapisane komendy w pliku robots.txt lub widziałem nieużywane już dyrektywy noindex. Warto pamiętać o tym, że w przypadku gdy robot otrzyma w pliku robots.txt dwie sprzeczne informacje to weźmie pod uwagę tę, która pozwoli mu crawlować podstrony serwisu.

15. Ostrożnie używaj narzędzia Google Disavow

Narzędzie do zrzekania się nienaturalnych linków przychodzących powstało, by można było zrzec się linków, które kiedyś zostały pozyskane dla witryny, a obecnie nie niosą za sobą wartości i stanowią potencjalne zagrożenie. Narzędzie to moim zdaniem jest przez część osób nadużywane. Stosuje się je, by wyczyścić profil odnośników lub by wykonać profilaktyczne zrzekanie się niechcianych linków przychodzących. Oba te scenariusze nie są poprawne. Użycie narzędzia disavow ma sens jedynie wtedy, gdy Google informuje nas o podjęciu ręcznych działań z uwagi na nienaturalne linki przychodzące. Stosowanie go w innych przypadkach w najlepszym razie nie będzie miało żadnych rezultatów dla witryny. Przy wyborze stron do zrzeczenia warto zwracać uwagę nie tylko na ich parametry, ale i na całą domenę (historia, profil linków), wygląd strony i odczucia wizualne w stosunku do podstrony, na której jest umieszczony link.

16. Nie bój się używać plików SVG

Google „rozumie” zawartość tych plików i potrafi je przetworzyć, co więcej w standardzie schema.org możliwe jest ich użycie np. w LocalBusiness. W sieci można zobaczyć udane przykłady wdrożeń więc warto zapamiętać tę informację 🙂

17. Dopracuj swoje znaczniki title

Nie od dziś wiadomo, że znacznik title pełni w pozycjonowaniu bardzo ważną rolę. Należy zadbać o to, by był on unikalny i odpowiednio długi. Nie oznacza to, że ma on posiadać x znaków, gdyż wartość ta jest reprezentowana w pikselach, a w dodatku jest różna dla różnych typów urządzeń. Znacznik title jest nieco dłuższy na urządzaniach mobilnych, a w wersji desktopowej minimalnie krótszy. Nie oznacza to, że Google nie bierze pod uwagę całości znacznika title – wręcz przeciwnie, możemy tworzyć długie i rozbudowane znaczniki, mając jednak świadomość, że użytkownik zobaczy w wynikach wyszukiwania jedynie część znacznika title.

18. Crawlowanie to nie indeksowanie

To, że strona zostanie odwiedzona przez robota wyszukiwarki Google nie oznacza, że zostanie ona umieszczona w indeksie Google dla danej strony. Podobnie rzecz się ma ze stronami, które posiadają znacznik meta noindex. Takie witryny nie znajdą się w indeksie, ale mimo wszystko będą crawlowane i analizowane przez robota wyszukiwarki Google.

19. Twórz treści na bazie pytań od użytkowników

Teksty na stronie oparte o pytania od użytkowników nieźle sobie radzą w wynikach wyszukiwania. Dobrą metodą jest odpowiadanie w tworzonych artykułach na najczęstsze pytania zadawane przez userów, co w połączeniu z użyciem danych strukturalnych może wygenerować dużo dodatkowych wejść na stronę. Taka treść spełnia też intencję użytkownika i odpowiada na jego zapytanie wysłane do wyszukiwarki Google, co oznacza, że ma większe szanse na znalezienie się na wyższych pozycjach niż treść o innym charakterze.

20. Różne znaczniki w różnych miejscach

Google uważa, że znacznik kanoniczny powinien być umieszczony tylko w sekcji head dokumentu. Dodanie go do innej sekcji (np. body) spowoduje, że znacznik ten zostanie zignorowany. Sytuacja wygląda podobnie w przypadku błędnego zapisu tego znacznika. Zupełnie inaczej Google interpretuje znaczniki noindex, które możemy umieścić w sekcji head. Jeśli taki znacznik znajdzie się w sekcji body lub będzie on błędnie zapisany to algorytm Google uzna, że strona nie powinna być zaindeksowana.

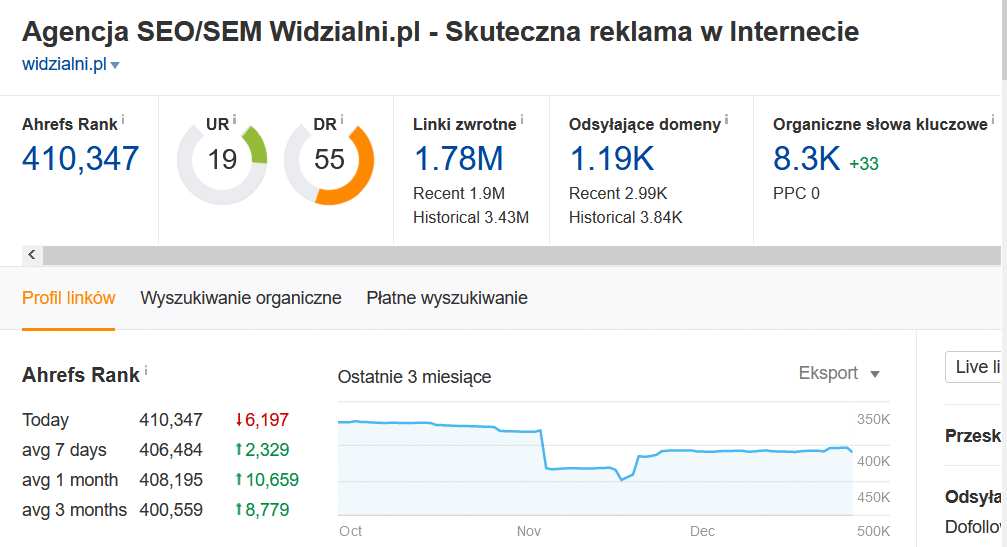

21. Używaj różnych narzędzi do analizy odnośników

W trakcie analizy linków przychodzących do witryny skupiamy się na jakości odnośników, ich ilości oraz domenach przychodzących anchorach. Na tej podstawie staramy się wyciągać wnioski.. Google Search Console nie pokazuje nam jednak wszystkich odnośników prowadzących do witryny, co wpływa na naszą ocenę. Nawet po wykonaniu kilku eksportów z różnymi parametrami nie uzyskamy wszystkich linków kierujących do strony. Duże i znane narzędzia takie jak Ahrefs czy Majestic też mogą nie pokazywać wszystkich linków – są bardzo często blokowane i to na poziomie blokad IP w pliku .htaccess, a nie na poziomie blokady w pliku robots.txt. Korzystanie z kilku narzędzi (w tym z tych mniej znanych) może pomóc w uzyskaniu lepszej bazy linków do analizy, co przekłada się na lepsze i bardziej precyzyjne wnioski.

22. Przygotuj się na migrację strony

Migracja strony na nowe oprogramowanie, zmiana szablonu graficznego czy nowe funkcjonalności – dla klienta brzmi niewinnie, ale w czasie, gdy są wykonywane takie czynności należy szczególnie uważać i zachować maksymalną czujność. Przede wszystkim ustalić termin migracji tak, by nie wypadał on w trakcie, gdy na stronie mamy największy ruch lub nieco wcześniej. Bardziej skomplikowane migracje mogą powodować nawet kilka miesięcy niższego ruchu. Sam proces przeniesienia strony nie powinien się odbywać w weekend czy święto. Prace najlepiej prowadzić w poniedziałkowy poranek – jest wówczas mnóstwo czasu na ewentualną reakcję. Przed migracją warto wykonać skan witryny i zebrać w ten sposób np. znaczniki title z obecnej wersji strony. Warto też wykonać mapę przekierowań i sprawdzić jak strona będzie się zachowywać po zmianach na wersji testowej.

23. Używaj strony w wersji HTTPS

Bezpieczna wersja strony to nie tylko plus dla użytkowników, ale przede wszystkim kolejna przewaga w SEO. Posiadanie SSL jest potwierdzonym przez Google czynnikiem rankingowym, dlatego warto zainwestować swój czas na instalację choćby darmowego certyfikatu SLL dla swojej strony. Podczas instalacji certyfikatu należy pamiętać o wykonaniu stosownych przekierowań 301 z wersji http na https. Po wdrożeniu warto sprawdzić stronę i zobaczyć, czy wszystkie zasoby, w tym obrazki i skrypty, są ładowane za pomocą bezpiecznego połączenia. Więcej na ten temat pisaliśmy na naszym blogu w artykule: Protokół HTTP i HTTPS – podstawowe różnice.

24. Nie korzystaj z tagu keywords

Pomimo tego, że Google jasno zasugerowało, że tag keywords nie jest przydatny w pozycjonowaniu, cały czas można spotkać strony, które go używają. Niektóre systemy CMS cały czas generują taki tag na podstawie pola, które jest uzupełniane przez użytkowników. Jest to zbędne działanie. Co więcej, może w łatwy sposób podpowiedzieć konkurencji pod jakie słowa kluczowe zoptymalizowana jest dana podstrona w serwisie. Google może nas też ukarać za nadmierne upychanie fraz kluczowych, dlatego warto całkowicie zrezygnować z tego znacznika.

25. Obserwuj swoją stronę

Zapewne znasz swoją stronę, widziałeś ją nieraz, ale czy na pewno? Stronę warto sprawdzać przede wszystkim w widoku mobilnym, bo jest to widok pierwszego wyboru dla robotów wyszukiwarki Google. Jeśli jakaś treść jest widoczna dla użytkowników na komputerze, ale nie jest widoczna dla użytkowników na smartfonach, to Google może jej nie pokazać w wynikach wyszukiwania. Warto też czasem oglądać swoją stronę z wyłączonymi stylami CSS oraz z wyłączoną obsługą JavaScript. Dzięki temu zabiegowi możemy zobaczyć np. rzeczywiste rozmiary obrazków czy treści, które są dostępne na stronie bez konieczności wykonywania plików JS. Warto też analizować swoją stronę ze zmienionym user agent, który symuluje Google Bota. Pozwoli to na zbadanie czy są różnice pomiędzy stroną dostępną dla użytkowników i dla robotów.

26. Uważaj na wyskakujące reklamy

Nic nie denerwuje bardziej niż reklama na pełną stronę czy wyskakujące okienko. Obecnie w tej kwestii jest zdecydowanie lepiej niż jeszcze kilka lat temu, gdy takie reklamy miały jeszcze uciekający przed użytkownikiem przycisk do zamykania okna reklamowego. Google stwierdziło jednak, że strony, które zakrywają treść wielkimi reklamami lub ich głównym celem jest wyświetlenie reklamy a nie pokazanie unikalnej i angażującej treści, będą nieco tracić w rankingu wyszukiwarki Google.

27. Przygotuj się na zapytania głosowe

Coraz więcej użytkowników odpytuje Google za pomocą Asystenta Google zadając mu pytanie w swoim naturalnym języku. Rok 2020 jest pod tym względem przełomowy, ponad 50% zapytań dla niektórych języków zostało wygenerowane za pomocą zapytań głosowych. W Polsce, z uwagi na specyfikę i trudność języka ten odsetek jest zdecydowanie mniejszy, co nie oznacza, że usługa Asystenta Google u nas nie działa. Wręcz przeciwnie, działa całkiem nieźle i rozumie coraz więcej. Warto przygotować się na nowy rodzaj zapytań i już teraz zacząć dostosowanie treści strony do specyfiki tak zadawanych przez użytkowników pytań.

28. Ustal jasną strukturę nagłówków na stronie

Każda podstrona serwisu powinna posiadać jeden nagłówek H1, który opisuje jej zawartość. Zwykle to, co znajduje się wewnątrz znacznika title będzie podobne do zawartości nagłówka H1 – nie jest to błąd. Warto też ustalić jasną strukturę nagłówków na stronie pamiętając o tym, by używać nagłówków H2 na śródtytułach oraz nagłówków niższego rzędu dla mniej znaczących informacji.

29. Pomóż Google ocenić swoją lokalną stronę

Ranking wyszukiwania zmienia się w zależności od lokalizacji użytkownika czy historii jego wyszukiwań. Wśród lokalnych czynników rankingowych znaleźć możemy między innymi ilość i jakość opinii o danej firmie np. w miejscach takich jak Google Maps. Stworzenie tam profilu i wejście w interakcję z użytkownikami zapewne pomoże podnieść pozycje w lokalnym rankingu wyszukiwania.

Zasady opisane powyżej to tylko część kwestii, na które należy zwrócić uwagę w czasie optymalizacji strony internetowej oraz jej pozycjonowania. Mnogość zagadnień oraz ich rozpiętość sprawia, że czasami trudno jest panować nad każdym aspektem SEO w witrynie.

Konieczność zapanowania nad kwestiami technicznymi, treściowymi, linkami czy autorytetem domeny sprawia, że pozycjonowanie stało się procesem bardzo złożonym, o wiele trudniejszym niż kilka lat temu.

Brak sekcji