Dlaczego warto optymalizować stronę – 15 uwag i odpowiedzi

Spis treści:

- 1. Tytuły stron – dlaczego są tak ważne?

- 2. Meta opisy strony – dlaczego warto wprowadzić?

- 3. Maskowanie (cloaking) – jakie ryzyko niesie ze sobą?

- 4. Powielenia zewnętrzne – dlaczego należy unikać?

- 5. Powielenia wewnętrzne – dlaczego należy unikać?

- 6. Nadmierna ilość słów kluczowych – dlaczego nie należy stosować?

- 7. Właściwe przekierowanie – dlaczego jest tak ważne?

- 8. Strona błędu 404 – dlaczego jej prawidłowe wdrożenie jest tak ważne?

- 9. Przyjazne adresy – dlaczego należy zastosować?

- 10. Tag Canonical – dlaczego należy wdrożyć?

- 11. Atrybut alt – dlaczego należy stosować?

- 12. Plik robots.txt – dlaczego należy zastosować?

- 13. Czas ładowania – dlaczego jest ważny?

- 14. Mapa witryny – dlaczego należy umieścić?

- 15. Treść na stronie – dlaczego jest potrzebna?

Przygotowując wytyczne optymalizacyjne strony internetowej klienta, często otrzymujemy od nich zapytania typu: czy wprowadzenie zmian jest konieczne? Dlaczego należy wdrożyć optymalizację? Czy dany element optymalizacji faktycznie wpłynie na proces pozycjonowania? By rozwiązać choć część pojawiających się wątpliwości, zebraliśmy najczęściej zadawane pytania i przygotowaliśmy krótkie wyjaśnienia. Mamy nadzieję, że uświadomią, jak bardzo pozycjoner ma rację, gdy wskazuje dany element do optymalizacji.

1. Tytuły stron – dlaczego są tak ważne?

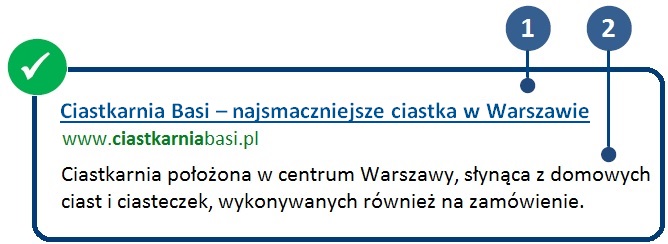

Celem tytułu i opisu strony jest jak najlepsze przedstawienie i opisanie każdego wyniku oraz wyjaśnienie, jaki ma on związek z zapytaniem użytkownika.

Tytuł strony jest ważny ponieważ wpływa nie tylko na pozycje strony w wynikach wyszukiwania, ale także na decyzje użytkowników dotyczące wyboru danej strony – często stanowi podstawową informację wyświetlaną w wynikach wyszukiwania. Jeżeli tytuł będzie dla odbiorcy interesujący oraz będzie zawierał słowa kluczowe poszukiwane przez użytkownika, zwiększy to szanse odwiedzenia witryny.

Więcej informacji na temat tytułów stron znajduje się TUTAJ.

2. Meta opisy strony – dlaczego warto wprowadzić?

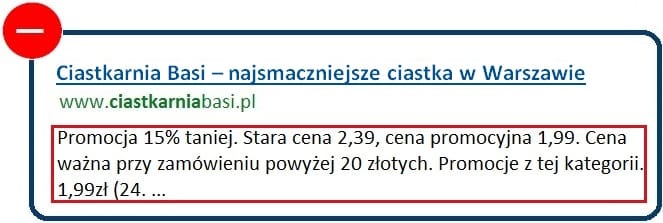

Meta opisy strony pozwalają na zawarcie zwięzłego i czytelnego dla użytkownika podsumowania zawartości strony. Jeżeli witryna nie posiada meta description lub w momencie gdy opis ten nie jest unikalny lub mało adekwatny do zapytania, Google utworzy snippet. Snippet to krótki tekst na podstawie zawartości jednej strony z witryny. Taki tekst zostanie umieszczony pod tytułem strony w wynikach wyszukiwania. Często się zdarza, że wygenerowany snippet nie jest wysokiej jakości, jak w przykładzie poniżej:

Dlatego też warto tworzyć unikalne, ciekawe i zachęcające użytkownika meta opisy stron (chociażby tylko dla głównych kategorii), które w znaczący sposób mogą przyczynić się do wzrostu konwersji ruchu na stronie.

Więcej informacji na temat meta opisów stron znajduje się TUTAJ.

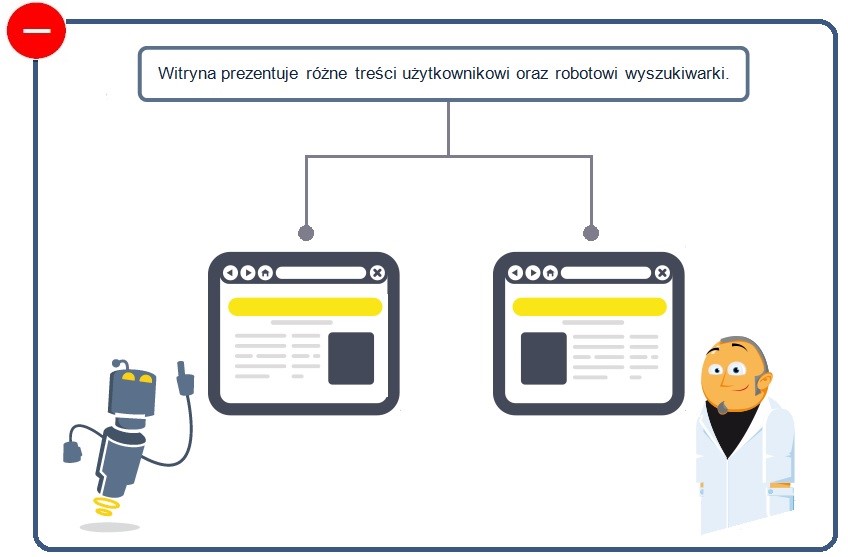

3. Maskowanie (cloaking) – jakie ryzyko niesie ze sobą?

Cloaking, czyli maskowanie, polega na prezentowaniu wyszukiwarkom innych treści, adresów URL, niż użytkownikom. Metoda ta uznawana jest za niezgodną z wytycznymi Google dla webmasterów, ponieważ powoduje wyświetlanie użytkownikom nieoczekiwanych treści. Strona za takie rozwiązania może zostać ukarana.

Więcej informacji na temat maskowania znajduje się TUTAJ.

4. Powielenia zewnętrzne – dlaczego należy unikać?

Unikalna treść jest kwestią szczególnie ważną, jeśli chodzi o optymalizację witryny pod wyszukiwarki. Występują dwa rodzaje powieleń: zewnętrzne i wewnętrzne.

Serwisy, które zawierają w większości skopiowane treści (nawet jeżeli są one wysokiej jakości), a jednocześnie nie oferują dodatkowych usług lub funkcji – nie są wartościowe dla użytkownika. Strona, na której w znacznej części występują takie powielenia, nie ma zbyt dużych szans na uzyskanie dobrej oceny jakości. Wręcz przeciwnie. Może zostać ukarana przez Google za liczne duplikaty. Witryna może zostać przesunięta na niższe pozycje, a w skrajnym przypadku całkowicie usunięta z wyników wyszukiwania.

5. Powielenia wewnętrzne – dlaczego należy unikać?

W wielu witrynach dostępne są tekstowe lub przeznaczone do drukowania wersje stron, stanowiące odpowiedniki stron o bogatszej szacie graficznej. Tworzenie tych samych lub podobnych stron dostępnych w obrębie witryny pod różnymi adresami URL nie jest wskazane ze względu na tworzenie się powieleń wewnętrznych, które są bardzo niekorzystne dla procesu pozycjonowania.

Jeśli w witrynie znajdują się materiały, do których można dotrzeć przy użyciu różnych adresów URL, należy wskazać właściwą, kanoniczną (preferowaną) wersje strony.

Więcej informacji na temat ustalania wersji kanonicznych znajduje się niżej w punkcie 10 dotyczącym Tag canonical oraz TUTAJ.

6. Nadmierna ilość słów kluczowych – dlaczego nie należy stosować?

Upychanie słów kluczowych, to niezgodna z wytycznymi Google praktyka, która polega na zapełnieniu witryny słowami kluczowymi na które chcemy wypozycjonować daną stronę. Stosowana jest w celu podwyższenia pozycji stron internetowych w wynikach wyszukiwania. Takie działania znacznie zmniejszają użytkownikowi wygodę korzystania z witryny, a także mogą przyczynić się do nałożenia kary na stronę.

7. Właściwe przekierowanie – dlaczego jest tak ważne?

Przekierowanie polega na odesłaniu użytkownika pod adres URL inny niż ten w oryginalnym żądaniu. Zastosowanie przekierowania z jednego adresu na drugi adres URL uzasadnione jest np. w przypadku przenoszenia witryny na nowy adres.

W przypadku konieczności zmiany adresu URL, wyświetlanego w wynikach wyszukiwania, zaleca się zastosowanie przekierowania 301. Kod 301 informuje roboty wyszukiwarek, że strona została na stałe przeniesiona do innej lokalizacji oraz pozwala uniknąć lub rozwiązać wiele problemów związanych z powielaniem się treści.

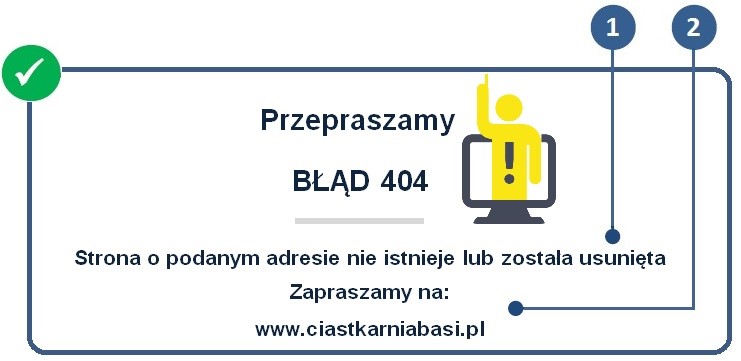

8. Strona błędu 404 – dlaczego jej prawidłowe wdrożenie jest tak ważne?

Strona błędu 404 jest wyświetlana w momencie, w którym w obrębie danego serwisu natrafimy na błędny lub nieistniejący już adres URL. W odpowiedzi na żądanie brakującej strony serwery internetowe wysyłają kod stanu HTTP 404 oznaczający, że strona nie została znaleziona.

Standardowe strony 404 zazwyczaj nie zawierają żadnych użytecznych informacji i większość użytkowników po prostu opuści Twoją witrynę. By tak się nie stało należy stworzyć dedykowaną stronę 404, gdzie wyświetlane będą treści przyjazne użytkownikowi:

- informacje o tym, że dana strona nie istnieje lub została usunięta,

- przykładowo: mapa serwisu, wyszukiwarka, odnośnik prowadzący do strony głównej, lista kategorii. Strona błędu 404 może być także zamieszczona na szablonie witryny, wtedy użytkownik będzie miał łatwy dostęp do najważniejszych sekcji witryny.

9. Przyjazne adresy – dlaczego należy zastosować?

Bardzo ważne jest, aby użytkownik poruszając się po witrynie w szybki i łatwy sposób odnalazł interesujące go treści. W poszukiwaniu właściwych treści adres URL niewątpliwie odgrywa ważną rolę. Odpowiednio utworzony, przyjazny adres, może pomóc użytkownikowi określić czy na danej stronie znajdzie treści, których szukał.

Zastosowanie przyjaznych adresów URL, także robotom wyszukiwarek ułatwia indeksowanie i zrozumienie najważniejszych treści zawartych na danej stronie.

10. Tag Canonical – dlaczego należy wdrożyć?

Aby uniknąć powieleń wewnętrznych, dany zasób (artykuł, produkt, etc.) powinien wyświetlać się jedynie pod jedną ścieżką dostępową. Jeżeli nie mamy możliwości utrzymania produktu wyłącznie pod jednym adresem należy stosować tag canonical, który umieszczony w kodzie danej podstrony wskazuje oryginalne źródło treści.

11. Atrybut alt – dlaczego należy stosować?

Atrybut alt to element strony przydatny zarówno wyszukiwarkom, jak i użytkownikom. Jest wymagany przez specyfikacje XHTML, stanowi obowiązkowy element znacznika IMG. Alternatywny opis obrazka jest wyświetlany w przypadku, gdy obrazek nie może zostać wczytany, jest także czytany przez specjalne programy dla osób z problemami wzroku, jako normalny tekst na stronie. Dlatego tak ważne jest odpowiednie formułowanie zawartości atrybutu alt. Roboty wyszukiwarek również nie analizują obrazów pod względem ich zawartości, dlatego posługują się opisami zawartymi w tym atrybucie.

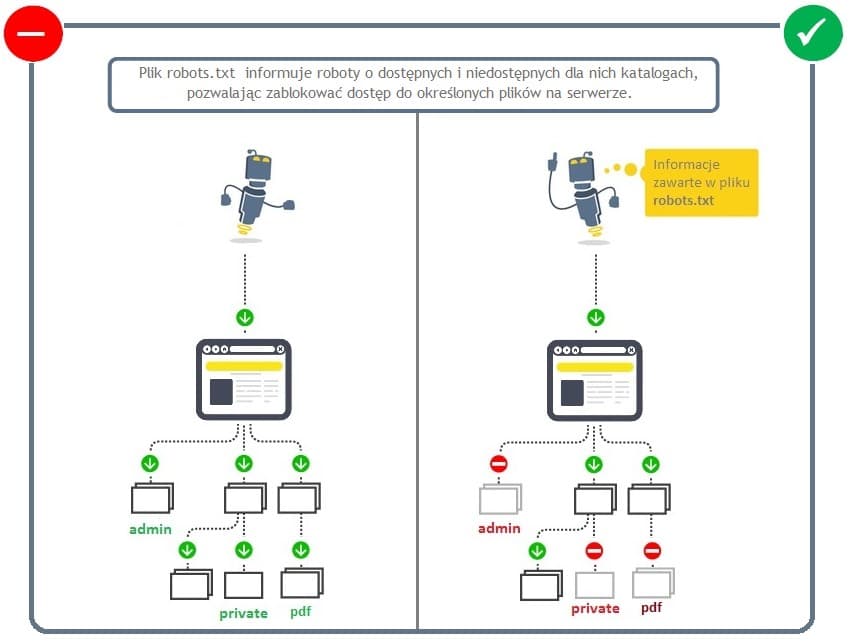

12. Plik robots.txt – dlaczego należy zastosować?

Plik robots.txt informuje roboty o dostępnych i niedostępnych dla nich katalogach, pozwalając zablokować dostęp do określonych (często newralgicznych) plików na serwerze. Należy zatem zastosować dany plik w obrębie witryny i zablokować dostęp do plików, folderów i części serwisu, które nie powinny być indeksowane przez roboty wyszukiwarek.

13. Czas ładowania – dlaczego jest ważny?

Celem Google jest zapewnianie użytkownikom najtrafniejszych wyników wyszukiwania i wygody korzystania z sieci. Wydajne witryny zapewniają większy komfort użytkowania i poprawiają ogólną jakość działania sieci, stąd też mają większą szanse uzyskania wyższych pozycji. Należy zatem monitorować czas ładowania zawartości witryny i jeżeli jest zbyt długi (zalecana wartość to maksymalnie 1 sekunda) należy stronę optymalizować.

14. Mapa witryny – dlaczego należy umieścić?

Mapa witryny przedstawia strukturę serwisu, zawiera szczegółowe informacje dotyczące wszystkich adresów URL. Pozwala to robotom wyszukiwarek szybciej zindeksować witrynę.

Przy pomocy map witryn możemy automatycznie informować wyszukiwarkę Google o wszystkich istniejących stronach i wszelkich ich aktualizacjach.

15. Treść na stronie – dlaczego jest potrzebna?

Treść zamieszczona na stronie musi być zarówno wartościowa dla użytkownika, spełniając jego wymagania, jak i przyjazna dla wyszukiwarki. Biorąc pod uwagę wyszukiwarki, tekst stanowi najważniejszy element witryny, ponieważ robot wyszukiwarki przeszukując strony internetowe opiera się na tekście. Przeszukiwania stron opierające się o tekst występują nawet wtedy, gdy mamy do czynienia z grafiką czy plikami video.

Ciekawa i wartościowa treść może zainteresować użytkownika i zachęcić do częstszego odwiedzania strony oraz do zamieszczania odnośników prowadzących do tych serwisów.

Nie wszystkie sugerowane zmiany jest łatwo wprowadzić. Niektóre z nich wymagają większych nakładów finansowych i pracy specjalistów. Warto jednak optymalizację strony wprowadzić, gdyż pozwala ona uzyskać dobre, stabilniejsze efekty, a dodatkowo jest to jedyny element w procesie pozycjonowania, nad którym mamy pełną kontrolę.

Brak sekcji

Z blokowaniem plików PDF to bym uważał ponieważ mogą zawierać istotne dane z punktu widzenia pozycjonowania i ich blokowanie trzeba dość dobrze przemyśleć 🙂

Jasne, że należy dobrze przemyśleć – tak jak zresztą każdą zmianę na stronie ;). W tym przypadku blokowanie pliku PDF stanowiło jedynie przykład, a nie regułę.

Cześć! Wspominasz o tym, by 404 zrobić jako osobną stronę. A czy dobrym wyjściem jest po prostu przekierowanie tego błędu na stronę główną? Dzięki!

Cześć 🙂 Błędne adresy jest sens przekierowywać na stronę główną (bądź inne podstrony, np. oferta, kontakt, etc.) pod warunkiem, że wiodą do nich wartościowe linki bądź generują jakiś ruch. Do takiej sytuacji może dojść, np. gdy ktoś zamieści na swojej stronie błędny link do naszego serwisu – szkoda wtedy tracić mocy bądź użytkowników.

Nie licząc tych wyjątkowych sytuacji, zdecydowanie lepiej jest posiadać osobną stronę błędu 404 (zwracającą poprawny nagłówek).

Dziękuję 🙂 W takim razie będę musiał przemyśleć u siebie osobną podstronę na to

Ciastkarnia Basi – przypadek?

Nie sądzę 🙂

bynajmniej 😉

Jeżeli chodzi o mapę witryny, to warto zaznaczyć, że ważna jest zarówno wersja w formacie XML, jak i zwykła, HTMLowa, przejrzysta dla użytkowników.

Ostatnio Google taki zapis w swoich wskazówkach wprowadziło:

„Prześlij plik mapy witryny z linkami do ważnych stron w witrynie. Udostępnij również stronę z listą linków do tych stron w postaci czytelnej dla człowieka (czasem nazywaną indeksem witryny lub stroną mapy witryny).”

Działanie pliku robots.txt w teorii wygląd tak jak na obrazku. W praktyce niekoniecznie. Niemniej fajny artykuł dla laików 🙂

Dzięki, taki właśnie miał być 🙂

Bardzo dobry artykuł dla tych, którzy dopiero zaczynają przygodę z SEO. Zabrakło mi tutaj jeszcze informacji, że strona powinna mieć jeden adres, albo z www, albo bez www.

[…] 3.Dlaczego warto optymalizować stronę – 15 uwag i odpowiedzi […]