Crawlery pomocne w trakcie wykonywania audytu SEO

W poprzedniej części cyklu dotyczącego narzędzi, które mogą się przydać w trakcie wykonywania audytu SEO, wspominaliśmy o pakiecie aplikacji dostarczanych przez Google. W tej części przedstawimy crawlery, które zbierają dane potrzebne do analizy strony.

Analiza kwestii technicznych w ramach audytu SEO jest czasochłonna. Ręczne wykonywanie takich procesów może nie dostarczyć zadowalających efektów z uwagi na konieczność przeglądu setek (czasem nawet tysięcy) podstron w poszukiwaniu błędów i problemów technicznych. Wykonując takie zadanie łatwo jest coś przeoczyć, dlatego też lepszym i efektywniejszym rozwiązaniem jest korzystanie z programów do crawlowania strony.

Crawlery SEO

Programy te potrafią analizować dużą ilość podstron pod kątem wielu czynników ważnych dla SEO. Zadanie to wykonywane jest automatycznie i wielowątkowo więc trwa znacznie krócej niż ręczny przegląd podstron. Daje też zdecydowanie lepsze efekty.

Na rynku dostępnych jest wiele narzędzi do sprawdzania serwisu pod kątem SEO. Brakuje jednak rozwiązań darmowych, w dodatku takich, które nadążają za zmianami w algorytmach Google. Każdy z dostępnych crawlerów różni się funkcjami i przeznaczeniem, ale co do zasady takie oprogramowanie powinno:

- sprawdzać status http podstron oraz notować łańcuchy przekierowań,

- sprawdzać ilość nagłówków,

- sprawdzać sekcję meta, zwłaszcza znacznik title oraz indeksację serwisu,

- liczyć znaki w treści i sprawdzać jej unikalność,

- kontrolować inne wskaźniki techniczne witryny.

Efektem końcowym pracy takiego programu jest raport podsumowujący znalezione błędy. W trakcie audytowania strony należy sprawdzić taki raport, potwierdzić zasadność znalezionych błędów oraz wyciągnąć wnioski, które można wykorzystać w audycie.

Crawlery są używane w technicznej analizie strony pod kątem występowania fraz kluczowych, nasycenia atrybutów alt oraz innych działań, które są wykonywane masowo dla wszystkich podstron w witrynie.

Ustawienia crawlowania

Każde z narzędzi posiada szereg ustawień, dzięki którym możemy podać parametry, z jakimi ma pracować oprogramowanie. Najczęściej spotykanymi są:

- wybór user agent,

- crawlowanie stron z wykorzystaniem uprawnień do ich oglądania (podając login i hasło),

- ograniczenie prędkości i głębokości analizowania,

- wyłączenie respektowania adresów kanonicznych i dyrektyw w pliku robots,

- ograniczenie analizy tylko do poszczególnych stron czy typów plików,

- wykonywanie skryptów JS.

Programy pokazane w dzisiejszym wpisie to subiektywny wybór autora tekstu. Każdy z nich jest inny i może być wykorzystany do innych celów – także niezwiązanych z audytem. W trakcie wykonywania takiego dokumentu warto się posiłkować kilkoma narzędziami, a wyniki ich analizy porównywać.

Xenu

Oprogramowanie to jest wiekowe, a jego ostatnia aktualizacja miała miejsce we wrześniu 2010 czyli, patrząc z perspektywy SEO, kilka epok temu. Powodem umieszczenia tego programu w poniższym zestawieniu jest funkcjonalność oprogramowania – Xenu zadziała niemal na każdej stronie. Gdy inne programy odmówią posłuszeństwa czy to poprzez brak pamięci, czy też błędy wewnętrzne, Xenu niemal zawsze przeanalizuje serwis.

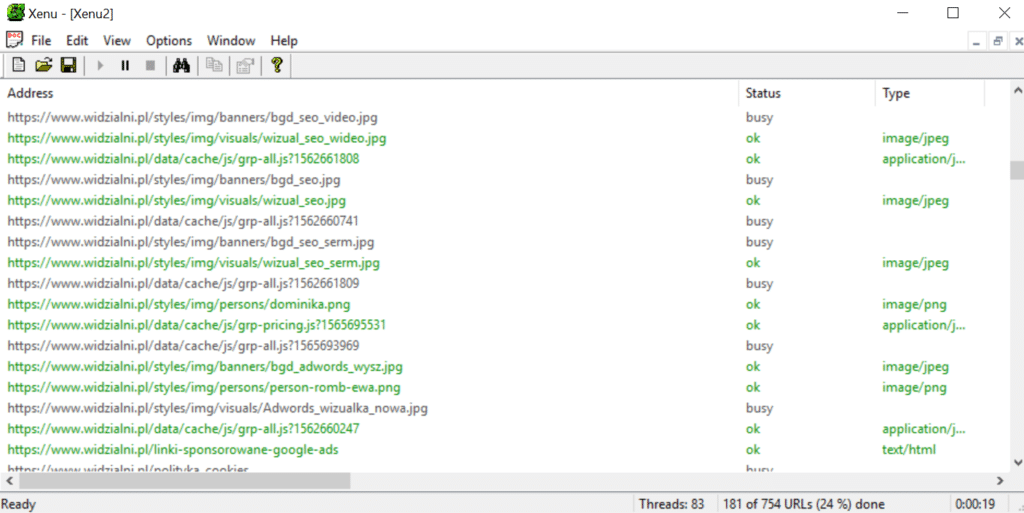

Interfejs tego narzędzia jest dość prosty. Po wybraniu strony do crawlowania możemy jedynie uwzględnić lub wykluczyć niektóre adresy z analizy. Program na bieżąco informuje nas o statusie prowadzonych prac oraz jego procentowym postępie.

Okno główne zawiera listę znalezionych przez program linków oznaczonych kolorami czarnym – link niesprawdzony, zielonym – link sprawdzony, nie znaleziono błędów, pomarańczowym – informacja do sprawdzenia oraz czerwonym – błąd podczas sprawdzania linku. W przypadku konieczności zalogowania program wyświetli stosowne powiadomienie.

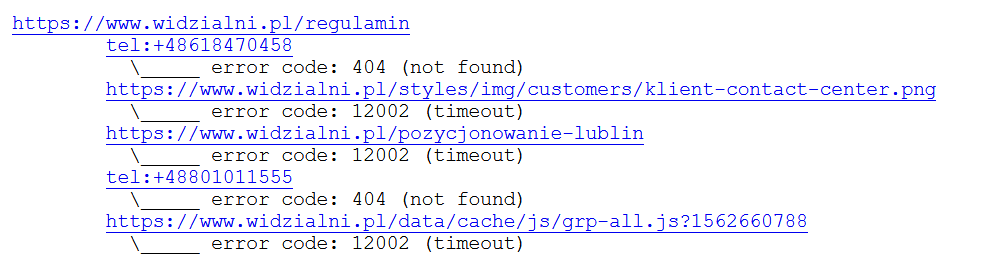

Wynik działania programu otrzymamy po skończonej analizie w pliku HTML. Dzięki niemu możemy sprawdzić jakie linki zwracają błędy (np. kod odpowiedzi 404). Błędy te możemy oglądać według strony docelowej oraz według linku.

Oprogramowanie to pozwala na dość pewną analizę podstron w szczególności w poszukiwaniu uszkodzonych linków wewnętrznych. Jego zaletą jest też szybkość i wielowątkowość.

WebSite Auditor

Program ten ma o wiele więcej opcji niż wcześniej wspomniany Xenu i pozwala na wykonywanie zdecydowanie szerszych analiz pod kątem SEO.

Konfiguracja crawlera pozwala na wykluczenie typów plików, ograniczenie crawlowania czy wykonanie pracy z wykorzystaniem proxy. Możemy też wybrać odpowiedniego user agent lub umożliwić wykonanie skryptów.

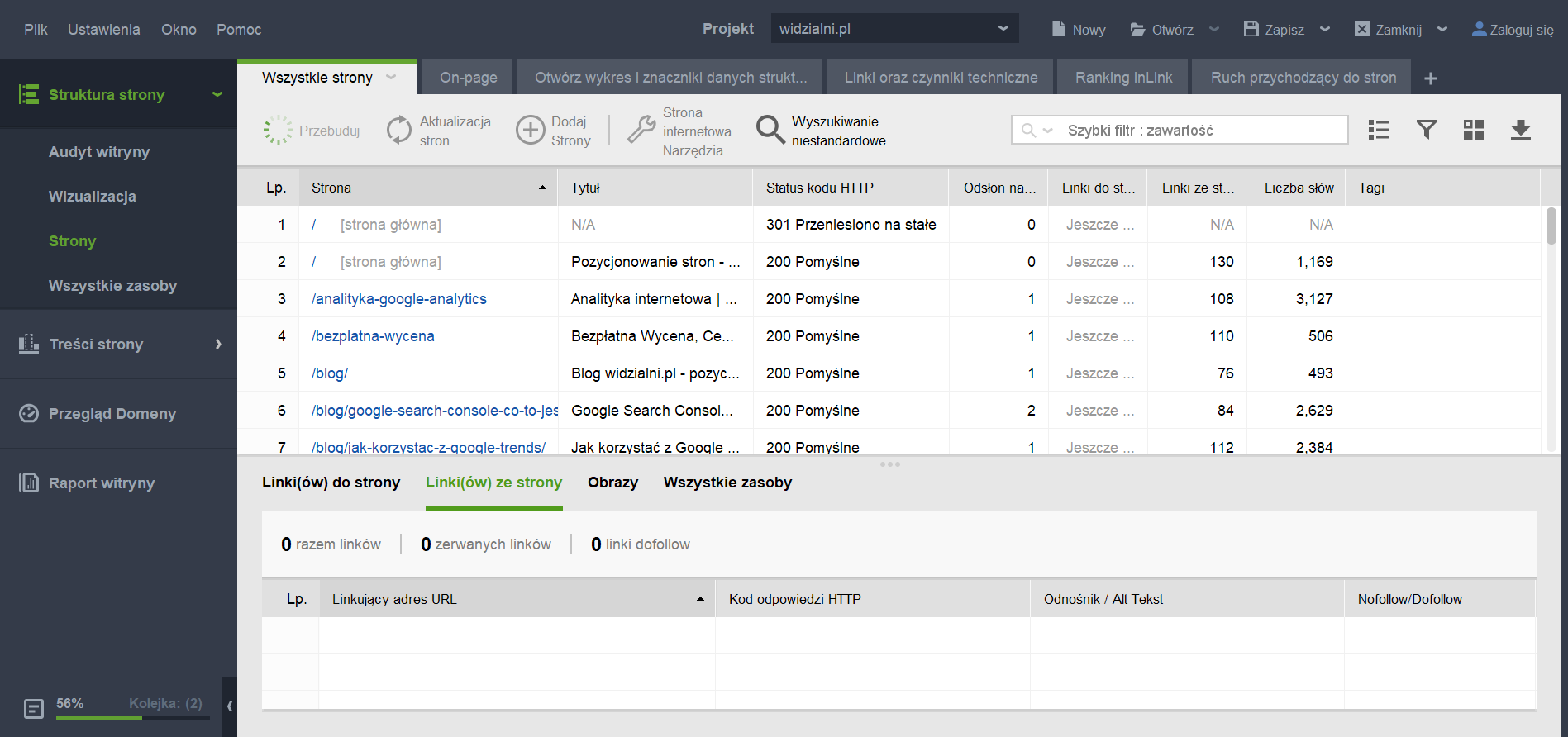

Okno programu w czasie pracy pokazuje nam listę zebranych adresów wraz ze sprawdzonymi parametrami. Warto zwrócić uwagę na zakładki znajdujące się w menu bocznym. To one pozwalają na szersze analizy już po zakończeniu zbierania adresów.

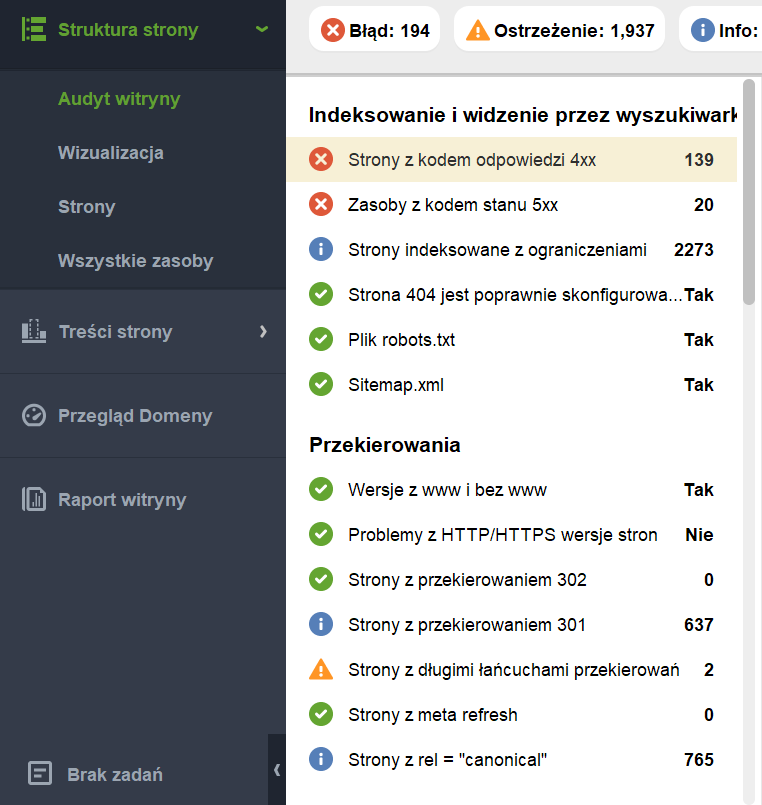

Wynikiem pracy programu jest zbiór wskazówek informujących, co można poprawić na stronie.

Każdą z nich można wyeksportować do pliku np. xls, dzięki czemu dysponujemy np. listą stron zwracających dany błąd. Możliwe jest też wygenerowanie raportu podsumowującego pracę programu, w którym znajdą się wszystkie błędy i ostrzeżenia.

Aplikacja ta jest bardzo często aktualizowana, dzięki czemu dostarcza wielu informacji na temat stanu witryny oraz kondycji poszczególnych podstron.

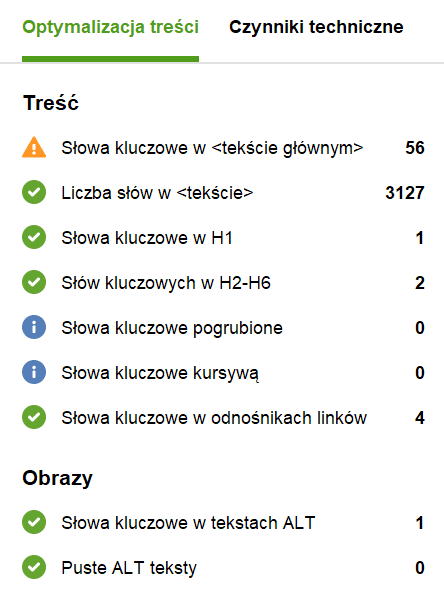

Z łatwością możemy sprawdzić powielone lub brakujące znaczniki czy też zweryfikować, które strony są zbyt duże lub mają zbyt długie i dynamiczne adresy. Możemy też przyjrzeć się sekcji treściowej – po wybraniu strony i wskazaniu słów następuje ich analiza z uwzględnieniem wszystkich miejsc istotnych dla pozycjonowania.

Screaming Frog

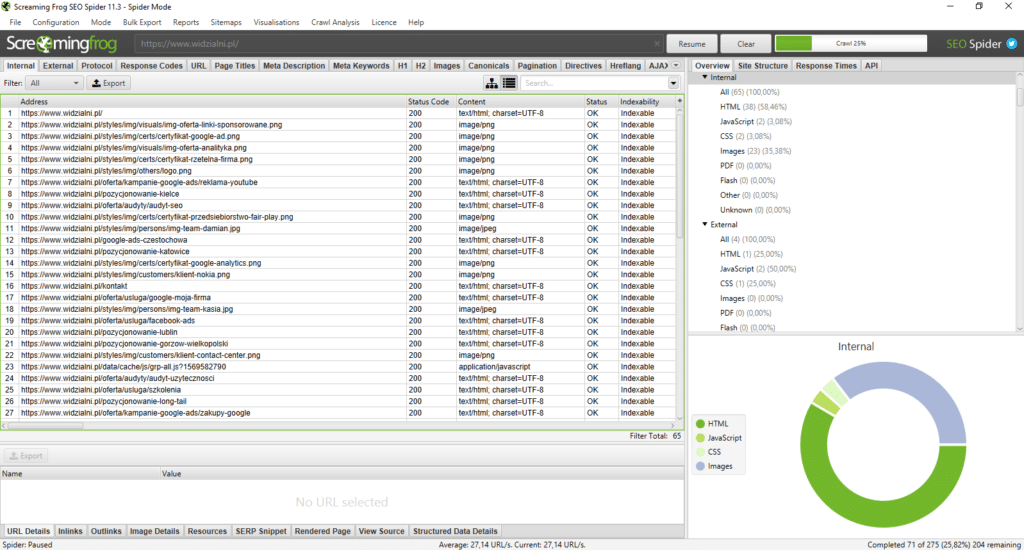

Program ten jest bardzo popularny i często wykorzystywany w czasie analiz stron www pod kątem pozycjonowania, także w trakcie wykonywania audytów SEO lub wytycznych optymalizacyjnych. Posiada bardzo dużo parametrów konfiguracyjnych – oprócz wymienionych już wcześniej, możemy np. wygenerować mapę XML podstron lub sprawdzić na ilu podstronach występuje szukany tekst.

Program sprawdza bardzo dużo czynników istotnych dla SEO.

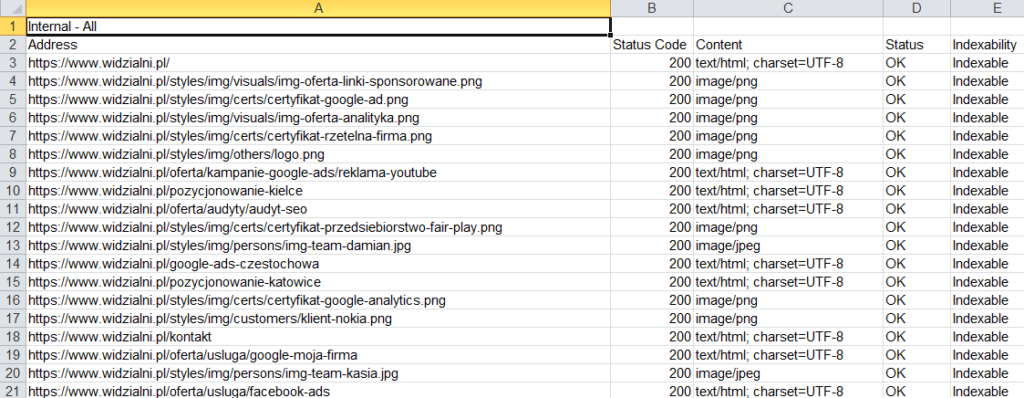

Po wykonanej analizie możemy przeglądać każdą z gałęzi, które zawierają listę stron spełniającą zadane kryteria. Taki surowy format danych sprawdzi się do szybszej i dokładniejszej analizy oraz do wykorzystania w innych narzędziach.

Każdą z analiz można wyeksportować do pliku jako listę podstron wraz z dodatkowymi informacjami.

Screaming Frog bardzo dobrze radzi sobie z crawlowaniem dużych serwisów. Dzięki mnogości opcji oraz dużej licznie sprawdzanych czynników jest szeroko wykorzystywany do audytowania stron www pod kątem SEO.

Podsumowanie

Wyżej wymienione aplikacje nie są oczywiście jedynymi programami do crawlowania stron www. Każdy z programów wykonuje inne testy i zbiera dane w nieco inny sposób. Różni się też interfejs użytkownika oraz końcowy raport, który otrzymujemy po zakończeniu prac.

Brak sekcji

Hej, osobom mniej doświadczonym w SEO polecam Pulno.com. To polski crawler, który analizuje stronę i podpowiada co warto poprawić na stronie. Podobnie jak WebSite Auditor generuje wyniki w postaci XLS, ale dodatkowo sprawdza jeszcze duplikację treści i ma integrację z Search Console.